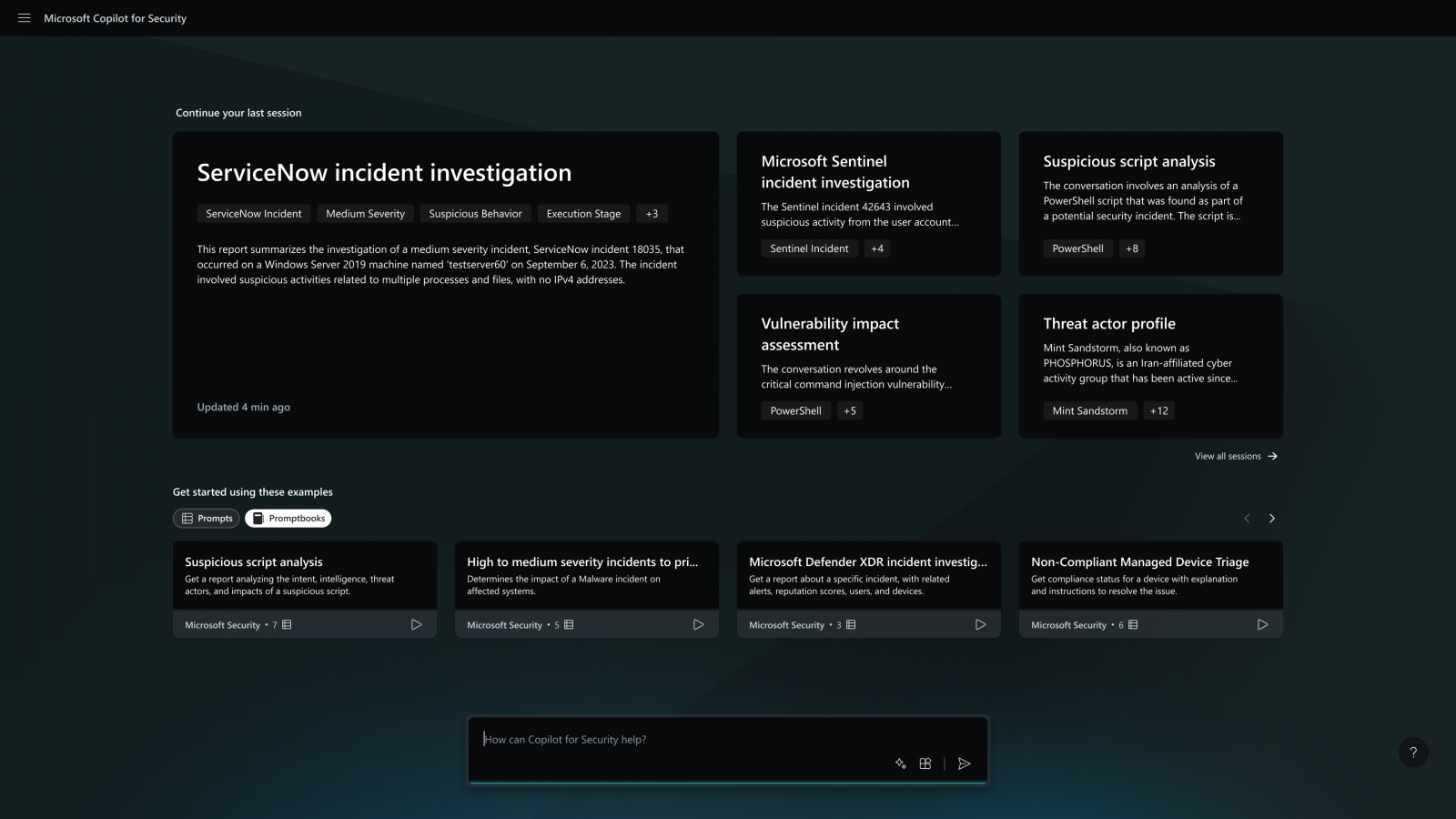

在資安領域,人工智慧(AI) 正引領一場巨大變革,AI 可協助企業組織以高速擊敗網路攻擊、解決資安人才短缺問題,並推動資安的創新和效率;攻擊威脅者也可利用 AI 提升攻擊效率及範圍。微軟發布第六期《Cyber Signals》研究報告,揭示攻擊威脅者如何運用AI提升攻擊效率並進行身份欺詐,以及微軟與OpenAI及MITRE 合作,透過 AI 的威脅偵測、行為分析、機器學習模型、零信任原則以及加強驗證,保護自身免受這類網路威脅攻擊侵害。 微軟與 OpenAI 及MITRE 合作 揭示國家級攻擊威脅行為的手法與路徑 為了確保安全、負責任地使用 ChatGPT 等 AI 技術,應堅持道德應用的最高標準,以保護社群免受潛在的AI濫用。微軟與 OpenAI 合作,揭露有關追蹤國家型攻擊者的手法與路徑,包括來自:俄羅斯的Forest Blizzard、北韓的Emerald Sleet、伊朗的Crimson Sandstorm、以及中國的Charcoal Typhoon 和 Salmon Typhoon。這些攻擊者試圖使用大型語言模型(LLMs)來增強其正在進行的網路攻擊行動。這項重要的研究揭示微軟觀察到這些攻擊者在 AI 方面採取的早期行動,並記錄微軟如何阻止他們的活動,以保護 AI 平台和用戶。 微軟亦公布指導及採取行動的原則,以減輕因為國家型持久攻擊威脅者、持久操縱者和使用 AI 平台和 API 的網絡犯罪集團帶來的風險。這些原則包括:識別和對惡意威脅行為者的行動、通知其他AI服務供應商的使用、與其他利害關係者合作以及提升透明度。 此外,微軟與 MITRE 合作,將這些 LLMs 主題的戰術、技術和程序(TTPs)整合到 MITRE ATT&CK® 框架或 MITRE ATLAS™(人工智慧系統對抗性威脅情境)知識庫中,以幫助更廣泛的資安社群了解和偵測大型語言模型 LLMs 在攻擊活動中的新藍圖。 AI 技術引發詐欺事件 身份驗證系統面臨挑戰 AI 引發的詐欺事件也是另一重要議題;語音合成技術的濫用就是一個例子,三秒的語音樣本可以訓練模型使其聽起來像任何人。必須了解惡意行為者如何利用 AI

[…]