马斯克xAI推出Grok-1.5大语言模型 可处理128k上下文

IT之家今日(3月29日)消息,马斯克旗下人工智能公司xAI今天在官方博客中宣布,正式推出Grok-1.5大语言模型。 Grok-1.5具有改进的推理能力和128k的上下文长度,其中最显著的改进之一是其在编码和数学相关任务中的表现。Grok-1.5将在未来几天内在????平台上向早期测试人员和现有的Grok用户推出。 在官方测试中,Grok-1.5在MATH基准上取得了50.6%的成绩,在GSM8K基准上取得了90%的成绩,这两个数学基准涵盖了广泛的小学到高中竞赛问题。此外,它在评估代码生成和解决问题能力的HumanEval基准测试中得分为74.1%。 附测试对比表如下: 长上下文理解方面,Grok-1.5能够在其上下文窗口内处理多达128ktokens的长上下文。这使得Grok的内存容量增加到之前上下文长度的16倍,从而能够理解更长文档中的信息。 据介绍,Grok-1.5构建在基于JAX、Rust和Kubernetes的自定义分布式训练框架之上。自定义训练协调器可确保自动检测到有问题的节点并将其从训练作业中剔除。xAI还优化了检查点、数据加载和训练作业重新启动,以最大限度地减少发生故障时的停机时间。

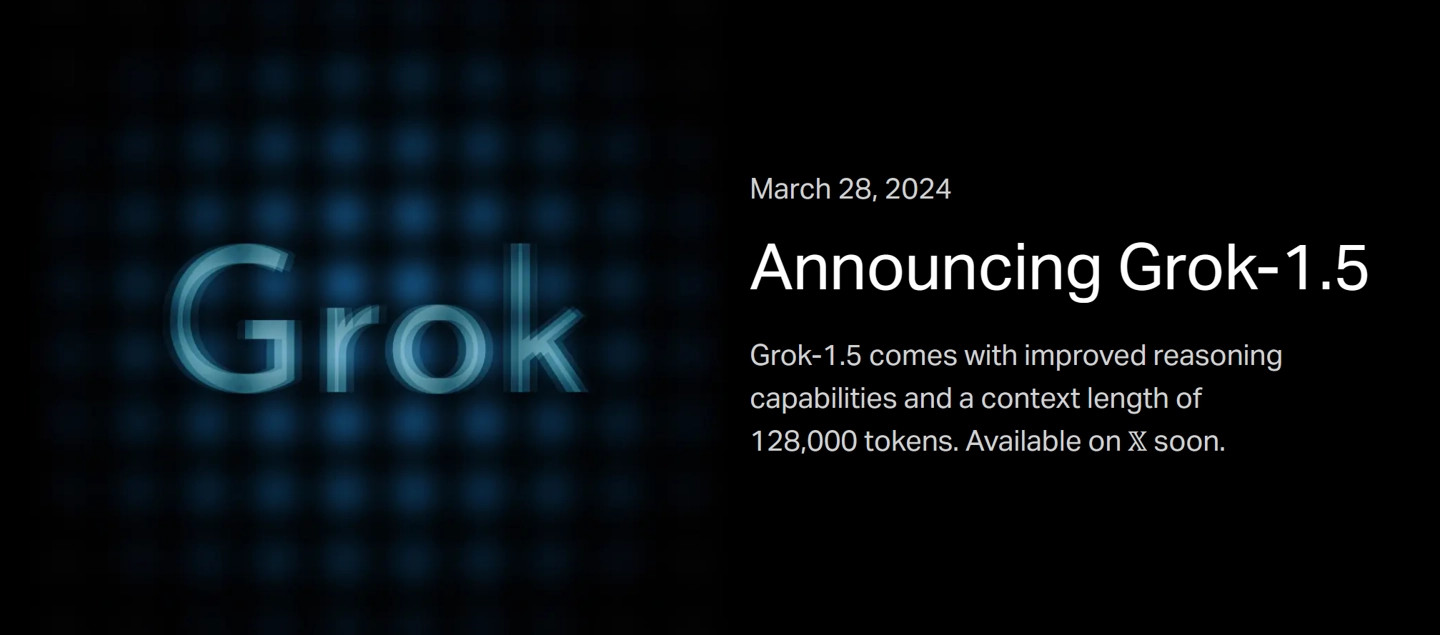

IT之家今日(3月29日)消息,马斯克旗下人工智能公司xAI今天在官方博客中宣布,正式推出Grok-1.5大语言模型。

Grok-1.5具有改进的推理能力和128k的上下文长度,其中最显著的改进之一是其在编码和数学相关任务中的表现。Grok-1.5将在未来几天内在????平台上向早期测试人员和现有的Grok用户推出。

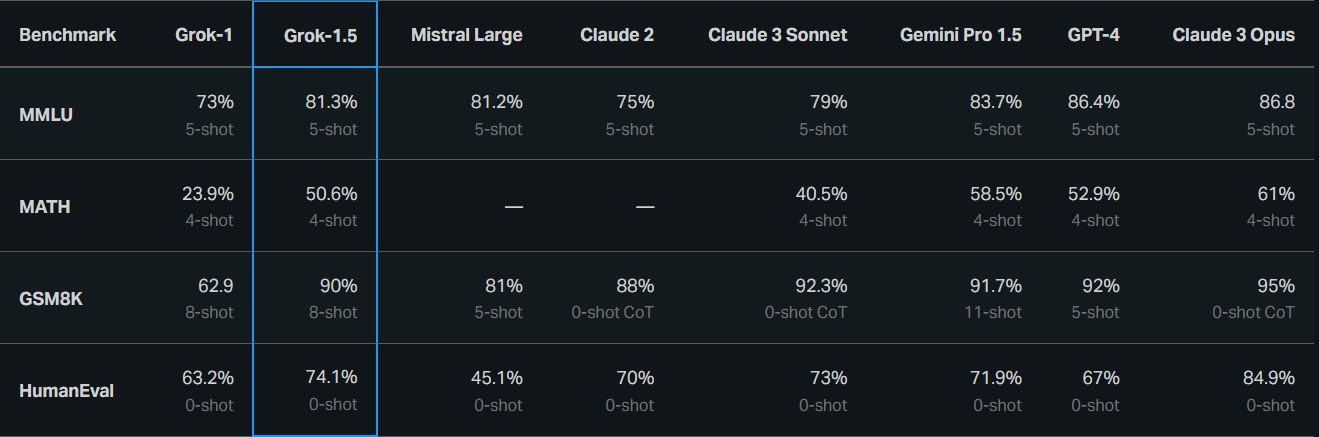

在官方测试中,Grok-1.5在MATH基准上取得了50.6%的成绩,在GSM8K基准上取得了90%的成绩,这两个数学基准涵盖了广泛的小学到高中竞赛问题。此外,它在评估代码生成和解决问题能力的HumanEval基准测试中得分为74.1%。

附测试对比表如下:

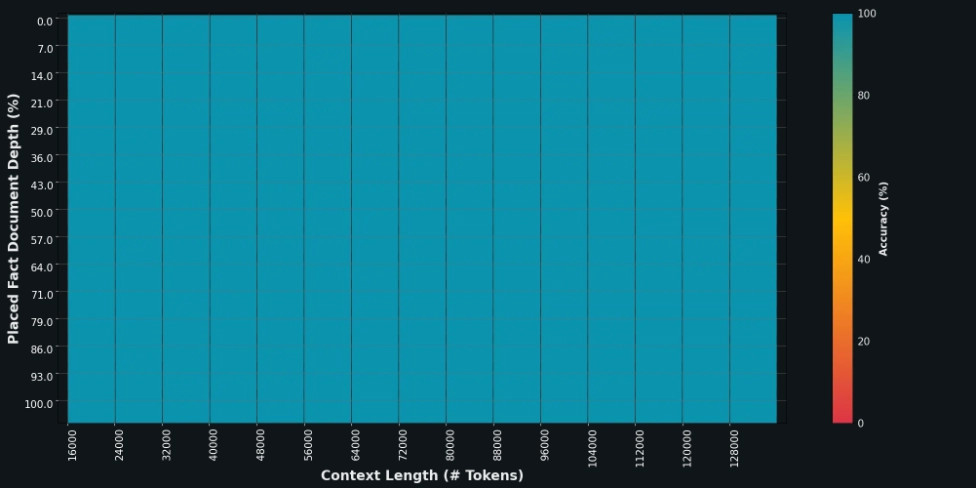

长上下文理解方面,Grok-1.5能够在其上下文窗口内处理多达128ktokens的长上下文。这使得Grok的内存容量增加到之前上下文长度的16倍,从而能够理解更长文档中的信息。

据介绍,Grok-1.5构建在基于JAX、Rust和Kubernetes的自定义分布式训练框架之上。自定义训练协调器可确保自动检测到有问题的节点并将其从训练作业中剔除。xAI还优化了检查点、数据加载和训练作业重新启动,以最大限度地减少发生故障时的停机时间。