首个中文原生DiT架构 腾讯混元文生图大模型宣布全面开源

快科技今日(5月14日)消息,今日,腾讯旗下混元文生图大模型(混元DiT,Diffusion Models with Transformers)宣布全面开源。 目前已在Hugging Face、Github上发布,包含模型权重、推理代码、模型算法等完整模型,供企业与个人开发者免费商用。 据媒体报道,腾讯混元文生图负责人卢清林表示,混元DiT开源的价值有两方面。 一方面这是业内首个中文原生DiT架构,弥补了开源社区的空白,另一方面混元DiT为全面开放,与现网版本完全一致。 据介绍,此次开源的混元DiT采用了与Sora同样的背后关键技术——DiT架构,还支持256字中文理解,不仅支持文生图,也可作为视频等多模态视觉生成的基础。 腾讯方面表示,为了构建混元DiT设计了Transformer结构、文本编码器和位置编码,构建了完整的数据管道,用于更新和评估数据,为模型优化迭代提供帮助。 为了实现细粒度的文本理解,还训练了多模态大语言模型来优化图像的文本描述。 最终,混元DiT能够与用户进行多轮对话,根据上下文生成并完善图像。

快科技今日(5月14日)消息,今日,腾讯旗下混元文生图大模型(混元DiT,Diffusion Models with Transformers)宣布全面开源。

目前已在Hugging Face、Github上发布,包含模型权重、推理代码、模型算法等完整模型,供企业与个人开发者免费商用。

据媒体报道,腾讯混元文生图负责人卢清林表示,混元DiT开源的价值有两方面。

一方面这是业内首个中文原生DiT架构,弥补了开源社区的空白,另一方面混元DiT为全面开放,与现网版本完全一致。

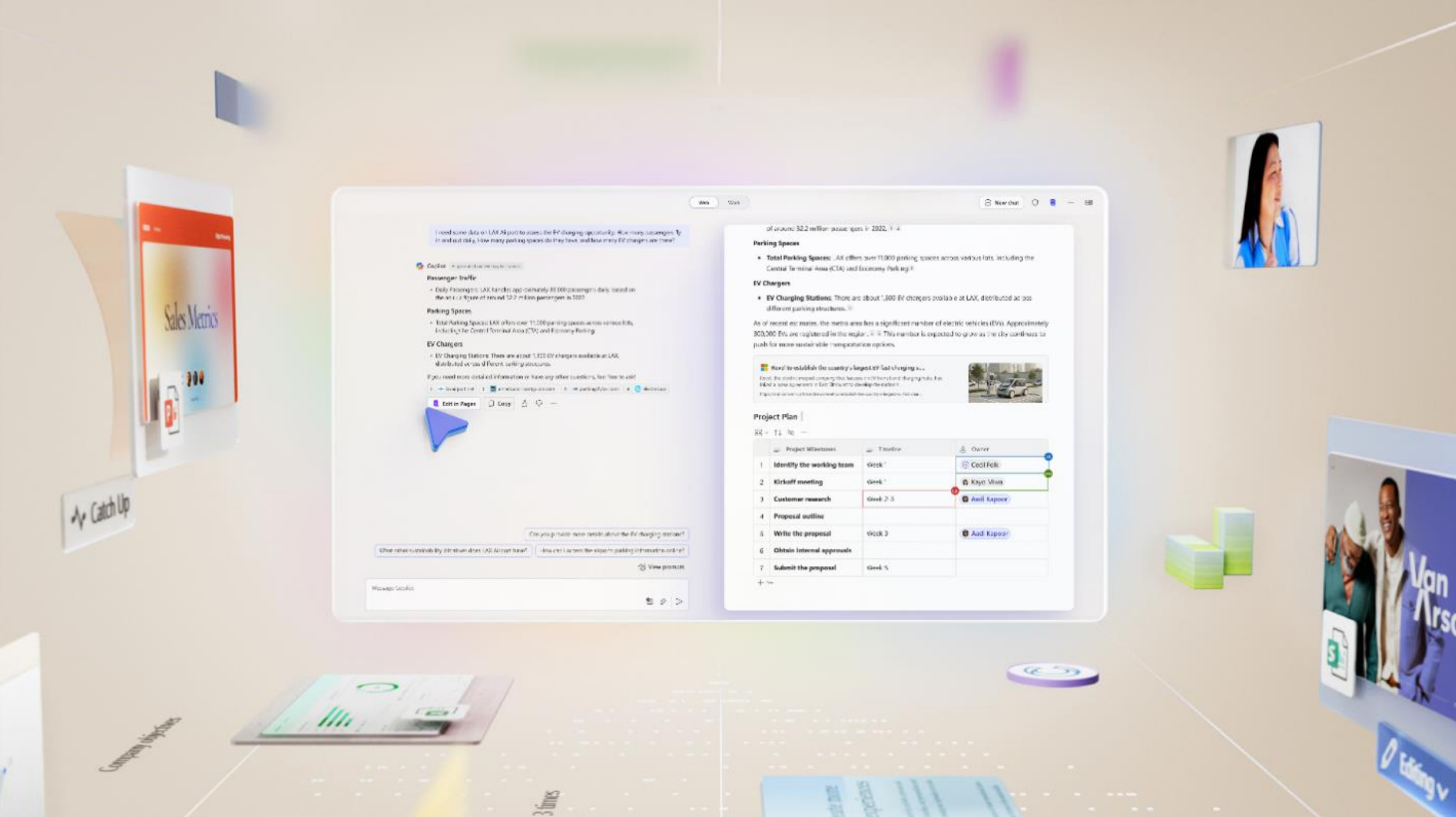

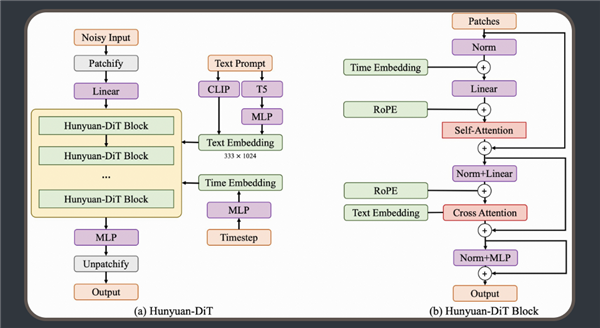

据介绍,此次开源的混元DiT采用了与Sora同样的背后关键技术——DiT架构,还支持256字中文理解,不仅支持文生图,也可作为视频等多模态视觉生成的基础。

腾讯方面表示,为了构建混元DiT设计了Transformer结构、文本编码器和位置编码,构建了完整的数据管道,用于更新和评估数据,为模型优化迭代提供帮助。

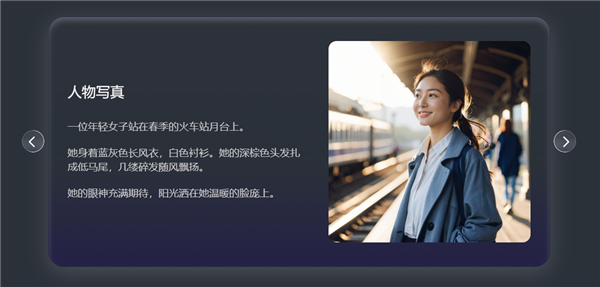

为了实现细粒度的文本理解,还训练了多模态大语言模型来优化图像的文本描述。

最终,混元DiT能够与用户进行多轮对话,根据上下文生成并完善图像。