英伟达推RTX聊天机器人 30和40系GPU免费使用

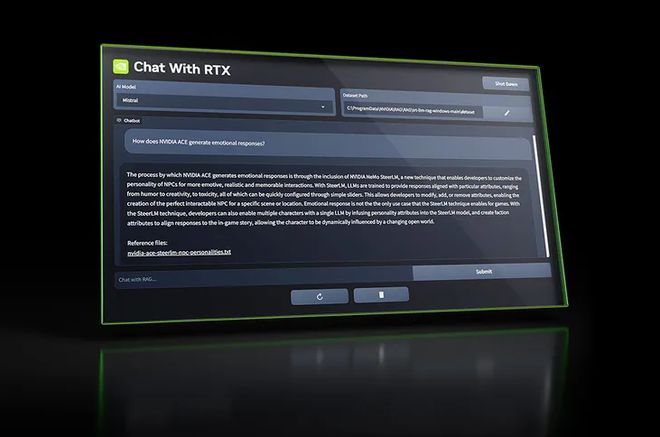

英伟达今天发布“Chat with RTX”(与 RTX 聊天)应用程序,这是一款适用于 Windows PC 的聊天机器人,由 TensorRT-LLM 提供支持。 “Chat with RTX”聊天机器人被设计为一个本地化系统,用户无需上网便可使用,所有具有至少 8 GB 显存的 GeForce RTX 30 和 40 GPU 都支持该应用程序。 Chat with RTX 支持多种文件格式,包括文本、pdf、doc / docx 和 xml。只需将应用程序指向包含文件的文件夹,它就会在几秒钟内将它们加载到库中。此外,用户还可以提供 YouTube 播放列表的 URL,该应用程序将加载播放列表中视频的转录,使用户能够查询它们涵盖的内容。 从官方描述来看,用户可以通过不同的查询,与使用 ChatGPT 相同的方式使用 Chat With RTX,但生成的结果将完全基于特定数据集,似乎更适用于生成摘要、快速搜索文档等操作。 拥有支持 TensorRT-LLM 的 RTX GPU 意味着用户将在本地使用所有数据和项目,而不是将它们保存在云中,这将节省时间并提供更精确的结果。 英伟达表示,TensorRT-LLM v0.6.0 将性能提升 5 倍,将于本月晚些时候推出。此外,它还将支持其他 LLM,如 Mistral 7B 和 Nemotron 3 8B。 获取更多RSS:https://feedx.net https://feedx.run

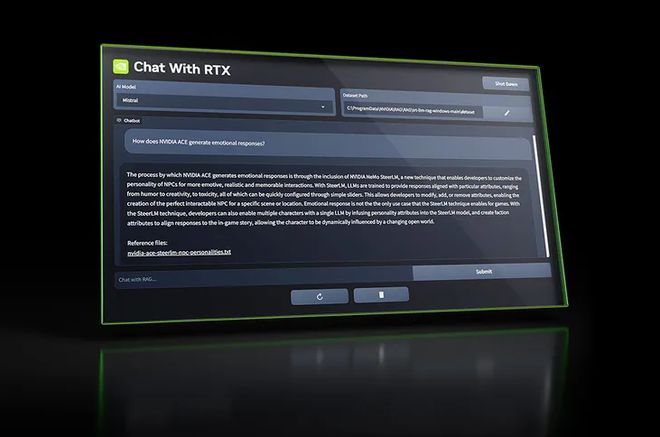

英伟达今天发布“Chat with RTX”(与 RTX 聊天)应用程序,这是一款适用于 Windows PC 的聊天机器人,由 TensorRT-LLM 提供支持。

“Chat with RTX”聊天机器人被设计为一个本地化系统,用户无需上网便可使用,所有具有至少 8 GB 显存的 GeForce RTX 30 和 40 GPU 都支持该应用程序。

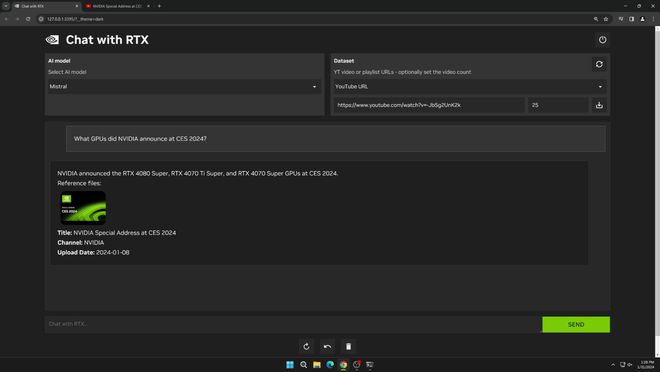

Chat with RTX 支持多种文件格式,包括文本、pdf、doc / docx 和 xml。只需将应用程序指向包含文件的文件夹,它就会在几秒钟内将它们加载到库中。此外,用户还可以提供 YouTube 播放列表的 URL,该应用程序将加载播放列表中视频的转录,使用户能够查询它们涵盖的内容。

从官方描述来看,用户可以通过不同的查询,与使用 ChatGPT 相同的方式使用 Chat With RTX,但生成的结果将完全基于特定数据集,似乎更适用于生成摘要、快速搜索文档等操作。

拥有支持 TensorRT-LLM 的 RTX GPU 意味着用户将在本地使用所有数据和项目,而不是将它们保存在云中,这将节省时间并提供更精确的结果。

英伟达表示,TensorRT-LLM v0.6.0 将性能提升 5 倍,将于本月晚些时候推出。此外,它还将支持其他 LLM,如 Mistral 7B 和 Nemotron 3 8B。