老黄抛出2700W功耗真核弹 还有240TB显存的AI超级计算机

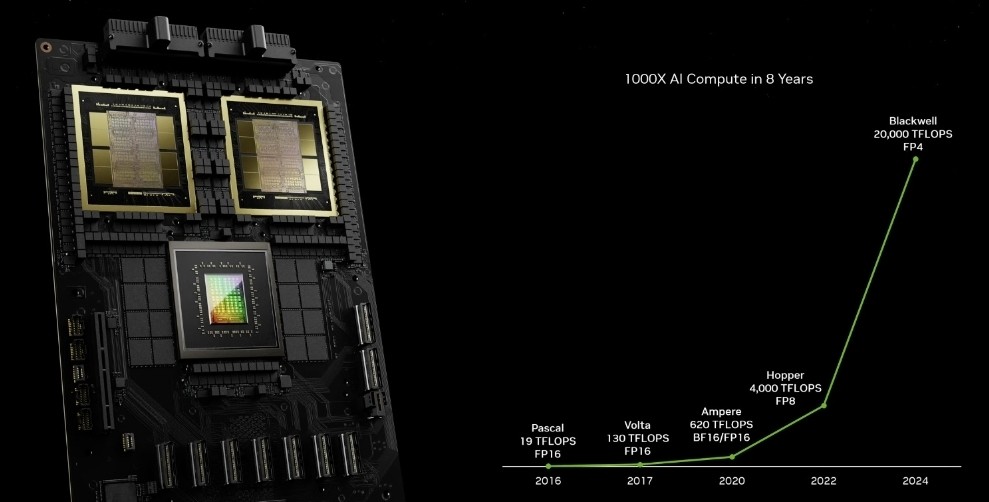

今天(3月19日)凌晨,黄仁勋正式拿出了新一代Blackwell GPU架构,以及基于此的B100/B200 GPU芯片、GB200超级芯片、DGX超级计算机,再次将“战术核弹”提升了全新的境界,傲视全球。 Blackwell B200 GPU首次采用了chiplet晶粒封装,包含两颗B100,而B200之间再通过带宽翻倍达1.8TB/s的第五代NVLink 5总线互连,最多可连接576块。 B100采用专门定制的台积电4NP工艺制造(H100/RTX 40 4N工艺的增强版),已经达到双倍光刻极限尺寸,彼此通过10TB/s带宽的片间互联带宽,连接成一块统一的B200 GPU。 B100集成多达1040亿个晶体管,比上代H100 800亿个增加了足足30%,B200整体就是2080亿个晶体管。核心面积未公布,考虑到工艺极限应该不会比814平方毫米的H100大太多。CUDA核心数量也没说,但肯定会大大超过H100 16896个,不知道能不能突破2万个? 每颗B100连接四颗24GB HBM3E显存/内存,等效频率8GHz,位宽4096-bit,带宽达4TB/s。如此一来,B200就有多达192GB HBM3E,总位宽8096-bit,总带宽8TB/s,相比H100分别增加1.4倍、58%、1.4倍。 性能方面,B200新增支持FP4 Tensor数据格式,性能达到9PFlops(每秒9千万亿次),INT/FP8、FP16、TF32 Tensor性能分别达到4.5、2.25、1.1PFlops,分别提升1.2倍、1.3倍、1.3倍,但是FP64 Tensor性能反而下降了40%(依赖GB200),FP32、FP64 Vector性能则未公布。 Blackwell GPU还支持第二代Transformer引擎,支持全新的微张量缩放,在搭配TensorRT-LLM、NeMo Megatron框架中的先进动态范围管理算法,从而在新型4位浮点AI推理能力下实现算力和模型大小的翻倍。 其他还有RAS可靠性专用引擎、安全AI、解压缩引擎等。至于功耗,B100控制在700W,和上代H100完全一致,B200则首次达到了1000W。英伟达宣称,Blackwell GPU能够在10万亿参数的大模型上实现AI训练和实时大语言模型推理。 GB200 Grace Blackwell是继Grace Hopper之后的新一代超级芯片(Superchip),从单颗GPU+单颗CPU升级为两颗GPU加一颗CPU,其中GPU部分就是B200,CPU部分不变还是Grace,彼此通过900GB/s的带宽实现超低功耗片间互联。 在大语言模型推理工作负载方面,GB200超级芯片的性能对比H100提升了多达30倍。不过代价也很大,GB200的功耗最高可达2700W,可以使用分冷,更推荐使用液冷。 基于GB200超级芯片,英伟达打造了新一代的AI超级计算机“DGX SuperPOD”,配备36块超级芯片,也就是包含36颗Grace CPU、72颗B200 GPU,彼此通过NVLink 5组合在一起,还有多达240TB HBM3E。 这台AI超级计算机可以处理万亿参数的大模型,能保证超大规模生成式AI训练和推理工作负载的持续运行,FP4精度下的性能高达11.5EFlops(每秒1150亿亿次)。 DGX SuperPOD还具有极强的扩展性,可通过Quantum-X800 InfiniBand网络连接,扩展到数万颗GB200超级芯片,并加入BlueField-3 DPU数据处理单元,而每颗GPU都能获得1.8TB/s的高带宽。 第四代可扩展分层聚合和规约协议(SHARP)技术,可提供14.4TFlops的网络计算能力,比上代提升4倍。 此外,英伟达还发布了第六代通用AI超级计算平台“DGX B200”,包含两颗Intel五代至强处理器、八颗B200 GPU,具备1.4TB HBM3E、64TB/s带宽,FP4精度性能144PFlops(每秒14亿亿次),万亿参数模型实时推理速度提升15倍。 DGX B200系统还集成八个英伟达ConnectX-7网卡、两个BlueField-3 DPU高性能网络,每个连接带宽高达400Gb/s,可通过Quantum-2 InfiniBand、Spectrum?-X以太网网络平台,扩展支持更高的AI性能。 基于Blackwell GPU的产品将在今年晚些时候陆续上市,亚马逊云、戴尔、谷歌、Meta、微软、OpenAI、甲骨文、特斯拉、xAI等都会采纳。 亚马逊云、谷歌云、微软Azeure、甲骨文云将是首批提供Blackwell GPU驱动实例的云服务提供商,英伟达云合作伙伴计划的中的Applied Digital、CoreWeave、Crusoe、IBM Cloud、Lambda也将提供上述服务。 Indosat Ooredoo Hutchinson、Nebius、Nexgen Cloud、甲骨文欧盟主权云、甲骨文美国/英国/澳大利亚政府云、Scaleway、新加坡电信、Northern Data Group旗下的Taiga Cloud、Yotta Data Services旗下的Shakti Cloud、YTL Power International 等主权AI云,也将提供基于Blackwell架构的云服务和基础设施。

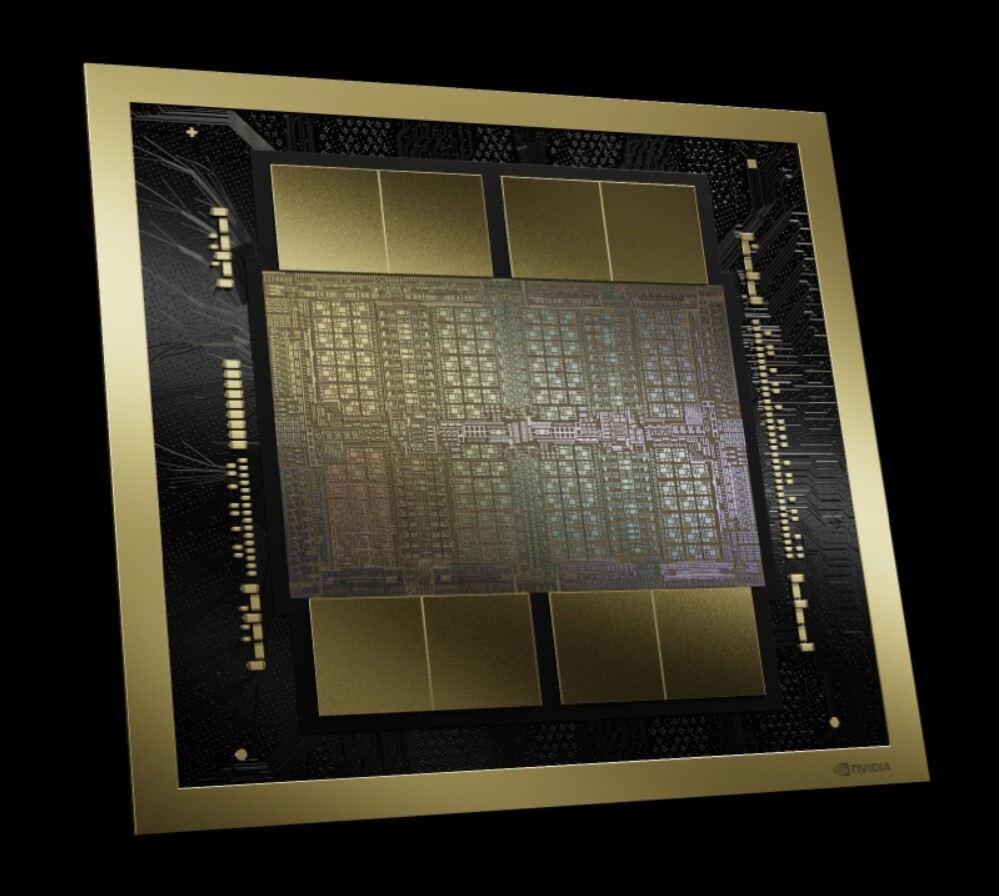

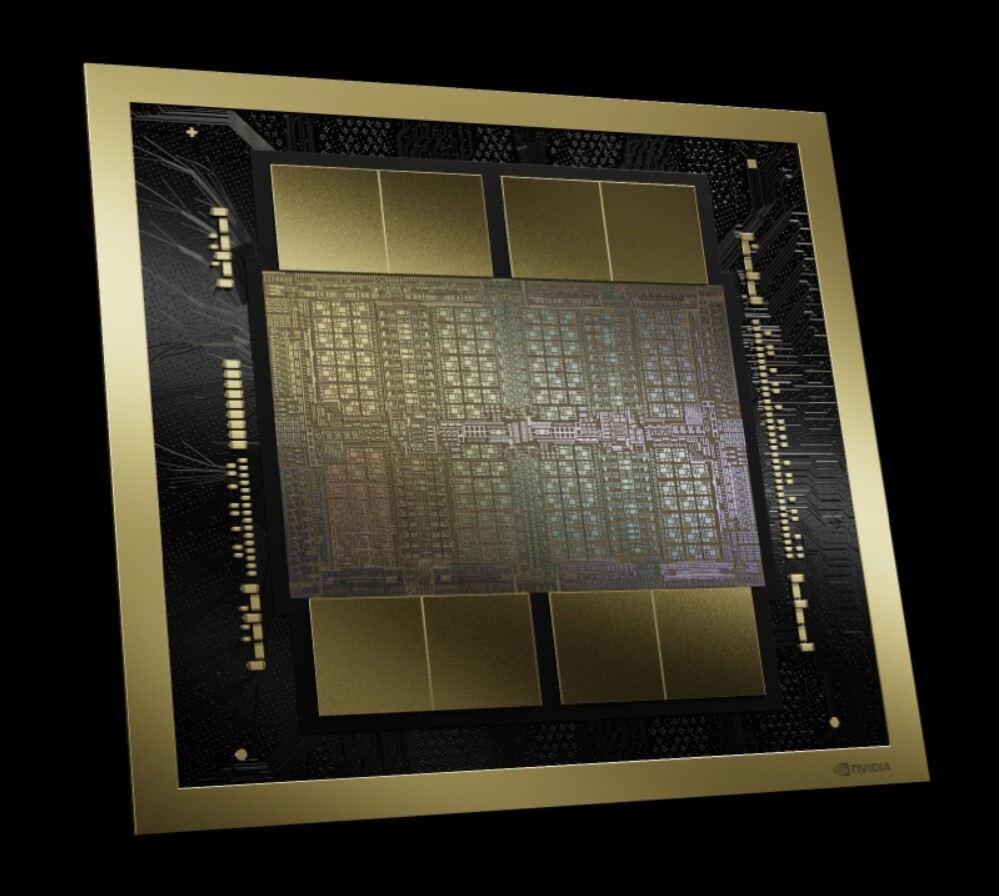

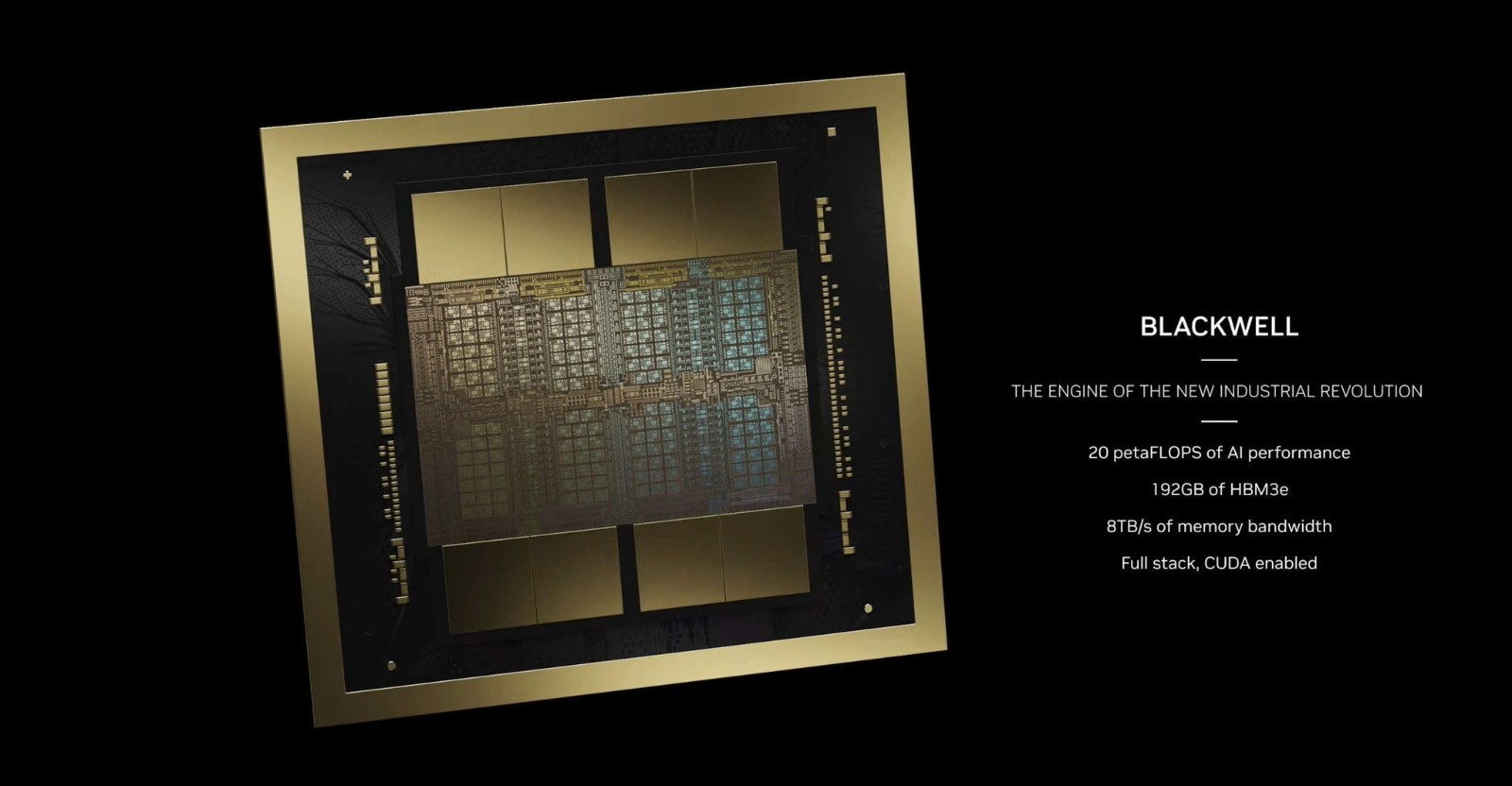

今天(3月19日)凌晨,黄仁勋正式拿出了新一代Blackwell GPU架构,以及基于此的B100/B200 GPU芯片、GB200超级芯片、DGX超级计算机,再次将“战术核弹”提升了全新的境界,傲视全球。

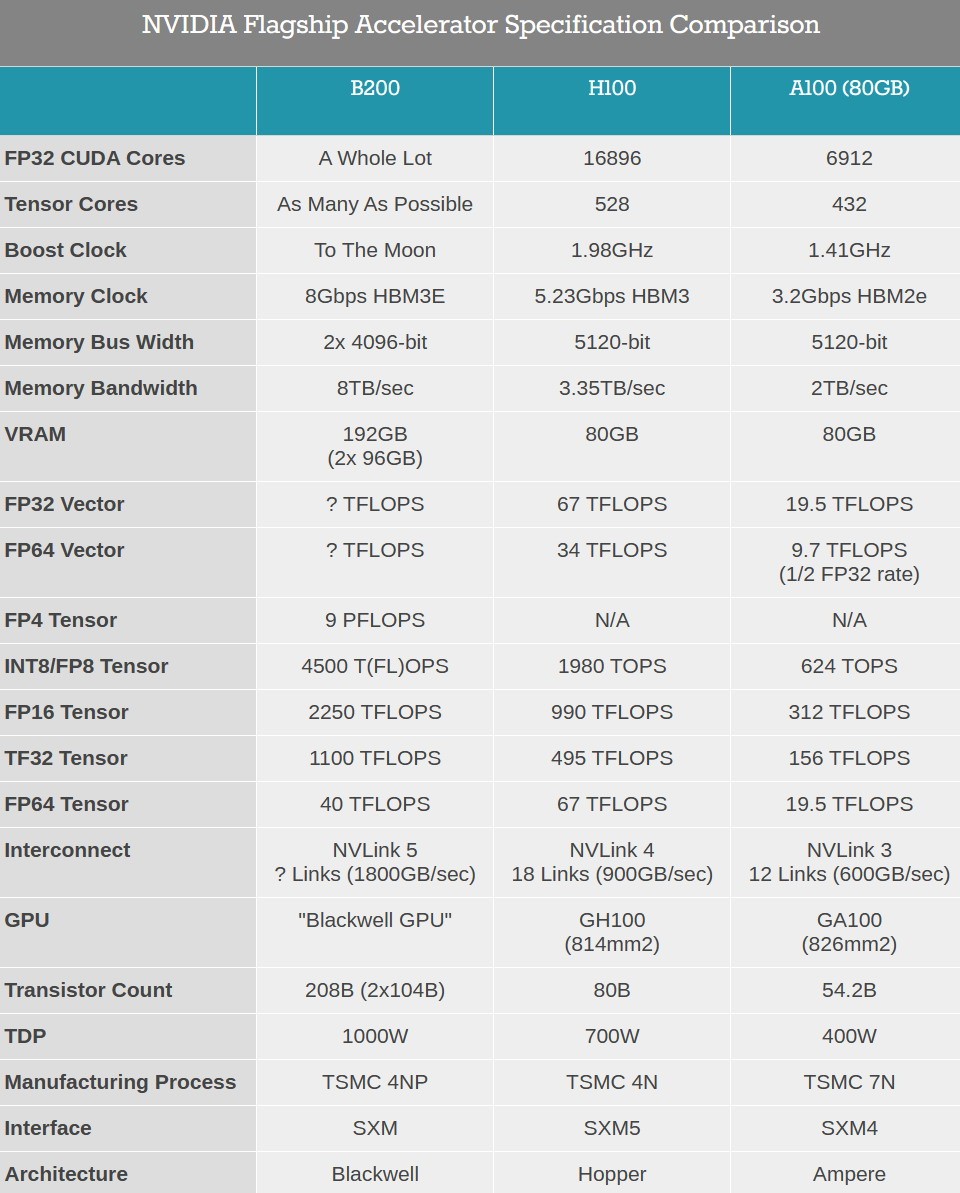

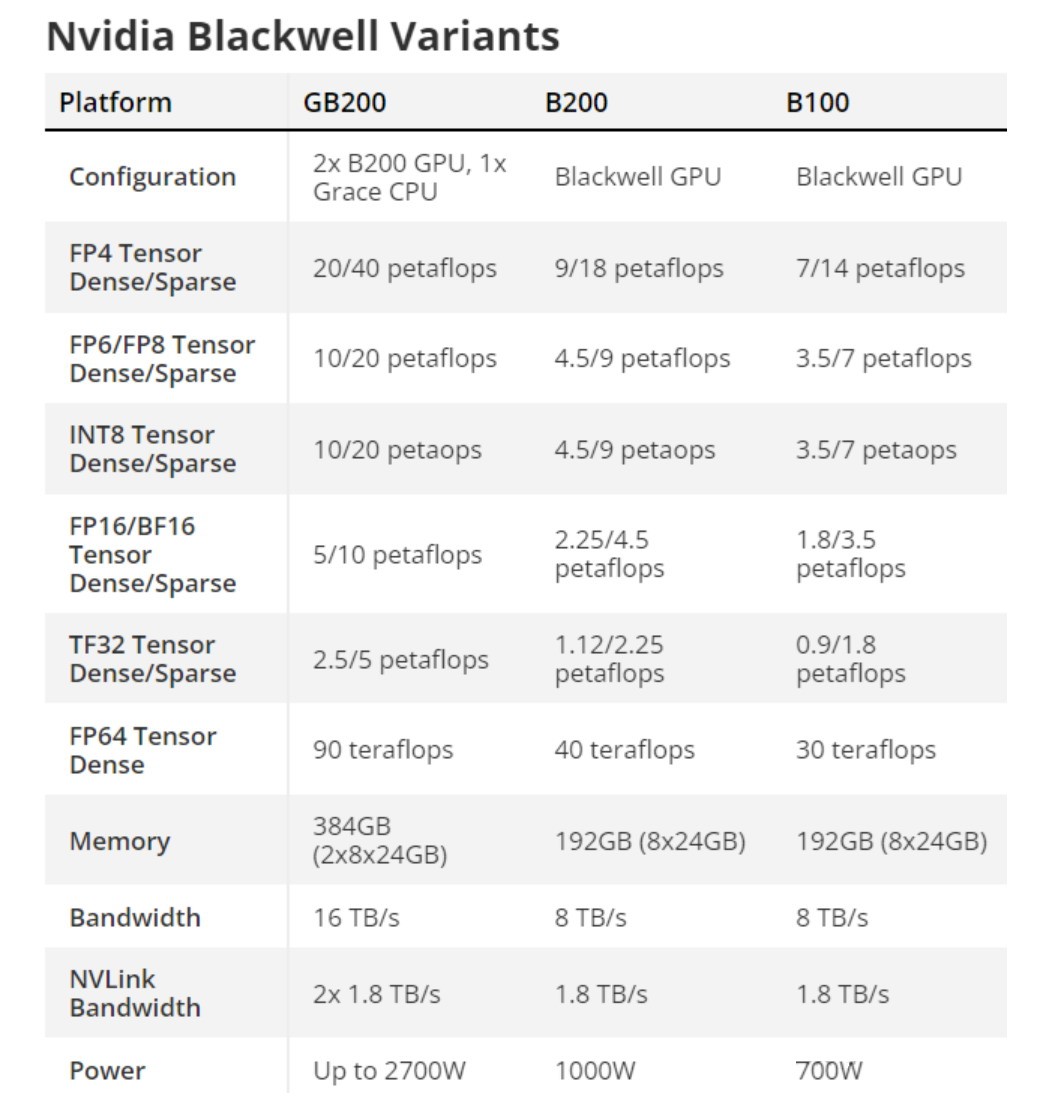

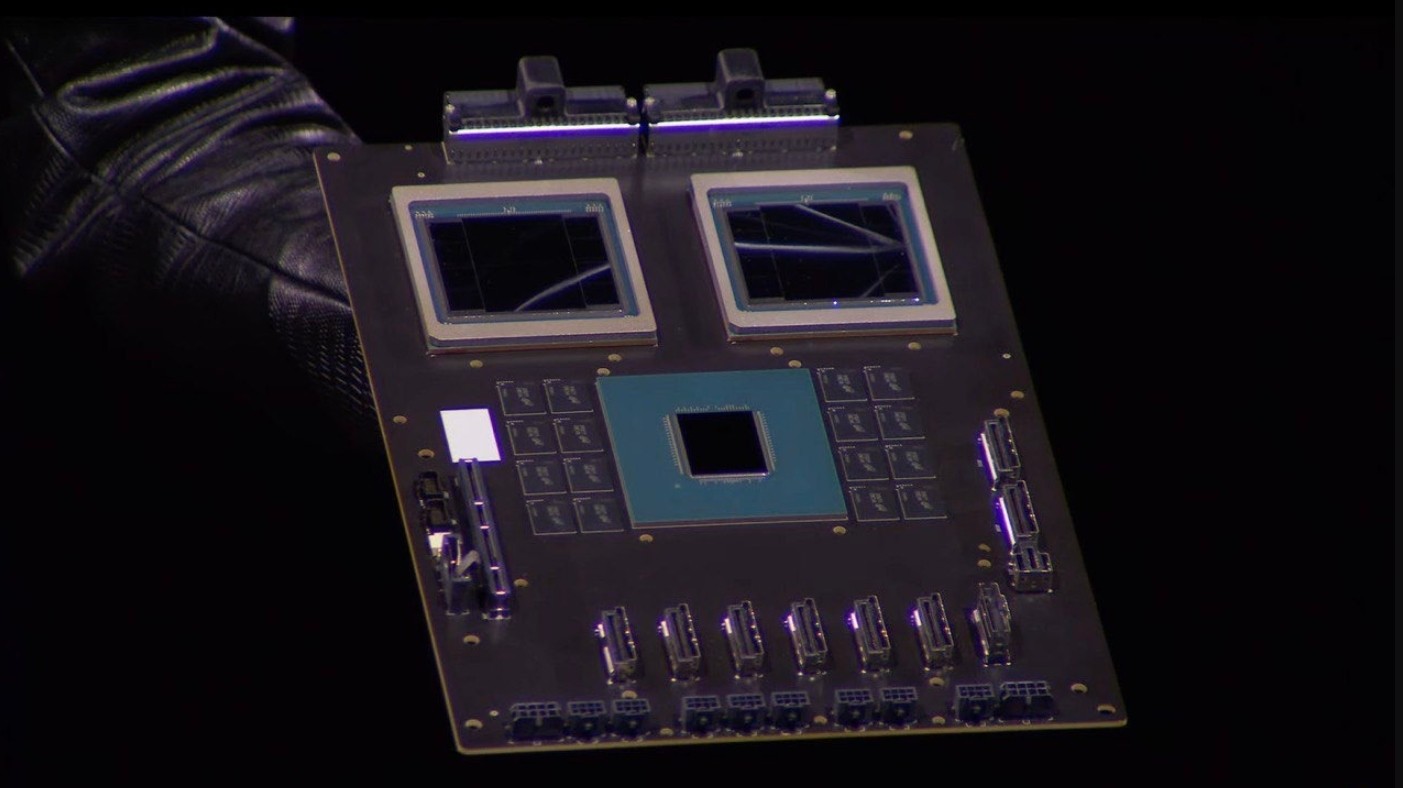

Blackwell B200 GPU首次采用了chiplet晶粒封装,包含两颗B100,而B200之间再通过带宽翻倍达1.8TB/s的第五代NVLink 5总线互连,最多可连接576块。

B100采用专门定制的台积电4NP工艺制造(H100/RTX 40 4N工艺的增强版),已经达到双倍光刻极限尺寸,彼此通过10TB/s带宽的片间互联带宽,连接成一块统一的B200 GPU。

B100集成多达1040亿个晶体管,比上代H100 800亿个增加了足足30%,B200整体就是2080亿个晶体管。核心面积未公布,考虑到工艺极限应该不会比814平方毫米的H100大太多。CUDA核心数量也没说,但肯定会大大超过H100 16896个,不知道能不能突破2万个?

每颗B100连接四颗24GB HBM3E显存/内存,等效频率8GHz,位宽4096-bit,带宽达4TB/s。如此一来,B200就有多达192GB HBM3E,总位宽8096-bit,总带宽8TB/s,相比H100分别增加1.4倍、58%、1.4倍。

性能方面,B200新增支持FP4 Tensor数据格式,性能达到9PFlops(每秒9千万亿次),INT/FP8、FP16、TF32 Tensor性能分别达到4.5、2.25、1.1PFlops,分别提升1.2倍、1.3倍、1.3倍,但是FP64 Tensor性能反而下降了40%(依赖GB200),FP32、FP64 Vector性能则未公布。

Blackwell GPU还支持第二代Transformer引擎,支持全新的微张量缩放,在搭配TensorRT-LLM、NeMo Megatron框架中的先进动态范围管理算法,从而在新型4位浮点AI推理能力下实现算力和模型大小的翻倍。

其他还有RAS可靠性专用引擎、安全AI、解压缩引擎等。至于功耗,B100控制在700W,和上代H100完全一致,B200则首次达到了1000W。英伟达宣称,Blackwell GPU能够在10万亿参数的大模型上实现AI训练和实时大语言模型推理。

GB200 Grace Blackwell是继Grace Hopper之后的新一代超级芯片(Superchip),从单颗GPU+单颗CPU升级为两颗GPU加一颗CPU,其中GPU部分就是B200,CPU部分不变还是Grace,彼此通过900GB/s的带宽实现超低功耗片间互联。

在大语言模型推理工作负载方面,GB200超级芯片的性能对比H100提升了多达30倍。不过代价也很大,GB200的功耗最高可达2700W,可以使用分冷,更推荐使用液冷。

基于GB200超级芯片,英伟达打造了新一代的AI超级计算机“DGX SuperPOD”,配备36块超级芯片,也就是包含36颗Grace CPU、72颗B200 GPU,彼此通过NVLink 5组合在一起,还有多达240TB HBM3E。

这台AI超级计算机可以处理万亿参数的大模型,能保证超大规模生成式AI训练和推理工作负载的持续运行,FP4精度下的性能高达11.5EFlops(每秒1150亿亿次)。

DGX SuperPOD还具有极强的扩展性,可通过Quantum-X800 InfiniBand网络连接,扩展到数万颗GB200超级芯片,并加入BlueField-3 DPU数据处理单元,而每颗GPU都能获得1.8TB/s的高带宽。

第四代可扩展分层聚合和规约协议(SHARP)技术,可提供14.4TFlops的网络计算能力,比上代提升4倍。

此外,英伟达还发布了第六代通用AI超级计算平台“DGX B200”,包含两颗Intel五代至强处理器、八颗B200 GPU,具备1.4TB HBM3E、64TB/s带宽,FP4精度性能144PFlops(每秒14亿亿次),万亿参数模型实时推理速度提升15倍。

DGX B200系统还集成八个英伟达ConnectX-7网卡、两个BlueField-3 DPU高性能网络,每个连接带宽高达400Gb/s,可通过Quantum-2 InfiniBand、Spectrum?-X以太网网络平台,扩展支持更高的AI性能。

基于Blackwell GPU的产品将在今年晚些时候陆续上市,亚马逊云、戴尔、谷歌、Meta、微软、OpenAI、甲骨文、特斯拉、xAI等都会采纳。

亚马逊云、谷歌云、微软Azeure、甲骨文云将是首批提供Blackwell GPU驱动实例的云服务提供商,英伟达云合作伙伴计划的中的Applied Digital、CoreWeave、Crusoe、IBM Cloud、Lambda也将提供上述服务。

Indosat Ooredoo Hutchinson、Nebius、Nexgen Cloud、甲骨文欧盟主权云、甲骨文美国/英国/澳大利亚政府云、Scaleway、新加坡电信、Northern Data Group旗下的Taiga Cloud、Yotta Data Services旗下的Shakti Cloud、YTL Power International 等主权AI云,也将提供基于Blackwell架构的云服务和基础设施。