谷歌发布全球最强开源大模型Gemma 可在笔记本运行

今日凌晨,Google宣布推出先进的轻量级开放模型系列Gemma,该模型采用了与创建 Gemini 模型相同的研究和技术。 Google表示,受到 Gemini 的启发,Google DeepMind 和 Google 其他团队合作开发了 Gemma,并用拉丁语中意为“宝石”的 gemma 为其命名。在发布模型权重的同时,还推出了一系列工具,旨在支持开发者创新,促进合作,并将指导开发者如何负责任地使用 Gemma 模型。 Google方面称,从今天起,Gemma 在全球范围内开放使用。将发布两种权重规模的模型:Gemma 2B 和 Gemma 7B。每种规模都有预训练和指令微调版本。 “新的 Responsible Generative AI Toolkit 为使用 Gemma 创建更安全的 AI 应用程序提供指导和必备工具。我们通过原生 Keras 3.0为所有主要框架(JAX、PyTorch 和 TensorFlow)提供推理和监督微调(SFT)的工具链。” 与此同时,主打上手即用,该模型与 Colab 和 Kaggle notebooks,以及与 Hugging Face、MaxText 和 NVIDIA NeMo 等受欢迎的工具集成,让开始使用 Gemma 变得简单容易。 更为重要的是,经过预训练和指令微调的 Gemma 模型可以在您的笔记本电脑、工作站或 Google Cloud 上运行,并可轻松部署在 Vertex AI 和 Google Kubernetes Engine(GKE)上。 在性能表现上,Gemma 在关键基准测试集上大大超过了更大的模型,同时还严格遵守了我们对安全和负责任输出的标准。 针对开发者,谷歌方面说明,开发者可以基于自己的数据微调 Gemma 模型以适应特定应用需求,例如摘要或检索增强生成 (RAG)。Gemma 可支持多种工具和系统: 1、多框架工具:Gemma 提供 Keras 3.0、原生 PyTorch、JAX 和 Hugging Face Transformers 多个框架的参考实现,您可以选择熟悉的框架进行推理和微调。 2、跨设备兼容:Gemma 模型可以在笔记本电脑、台式机、物联网、移动设备和云端等多个主流设备类型上运行,支持广泛的 AI 功能。 3、前沿的硬件平台: 我们与 NVIDIA 合作,使用 NVIDIA GPU 来优化 Gemma 模型,确保业界领先的性能与前沿技术的整合应用。 4、基于 Google Cloud 的优化:Vertex AI 提供广泛的 MLOps 工具集,其中包含一系列微调选项和内置推理优化的一键部署功能。您可以使用完全托管的 Vertex AI 工具或自行管理的 GKE 来进行高级定制,以经济高效的方式自行选择部署在 GPU、TPU 或 CPU 基础设施上。 在负责任方面,Gemma 在设计时将 AI 原则放在首位。为了使 Gemma 预训练模型安全可靠,谷歌使用自动技术,从训练集中过滤掉特定的个人信息及其他敏感数据。此外,我们进行了大量的微调和人类反馈强化学习(RLHF),使指令微调模型与负责任的行为保持一致。 谷歌方面表示,为了解并降低 Gemma 模型带来的风险,谷歌进行了强有力的评估,包括手工红队测试、自动对抗性测试,以及对危险活动的模型能力评估。

今日凌晨,Google宣布推出先进的轻量级开放模型系列Gemma,该模型采用了与创建 Gemini 模型相同的研究和技术。

Google表示,受到 Gemini 的启发,Google DeepMind 和 Google 其他团队合作开发了 Gemma,并用拉丁语中意为“宝石”的 gemma 为其命名。在发布模型权重的同时,还推出了一系列工具,旨在支持开发者创新,促进合作,并将指导开发者如何负责任地使用 Gemma 模型。

Google方面称,从今天起,Gemma 在全球范围内开放使用。将发布两种权重规模的模型:Gemma 2B 和 Gemma 7B。每种规模都有预训练和指令微调版本。

“新的 Responsible Generative AI Toolkit 为使用 Gemma 创建更安全的 AI 应用程序提供指导和必备工具。我们通过原生 Keras 3.0为所有主要框架(JAX、PyTorch 和 TensorFlow)提供推理和监督微调(SFT)的工具链。”

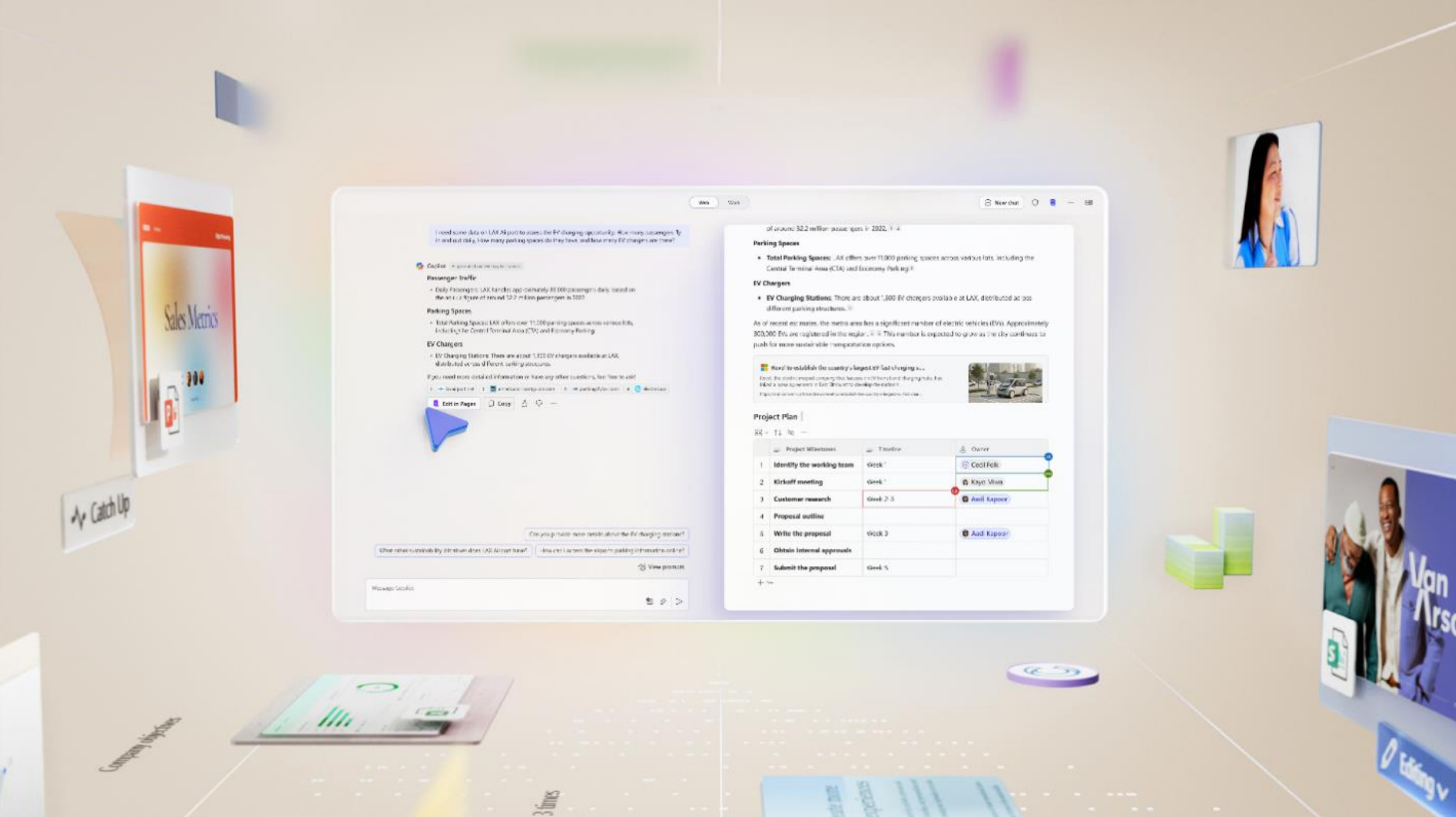

与此同时,主打上手即用,该模型与 Colab 和 Kaggle notebooks,以及与 Hugging Face、MaxText 和 NVIDIA NeMo 等受欢迎的工具集成,让开始使用 Gemma 变得简单容易。

更为重要的是,经过预训练和指令微调的 Gemma 模型可以在您的笔记本电脑、工作站或 Google Cloud 上运行,并可轻松部署在 Vertex AI 和 Google Kubernetes Engine(GKE)上。

在性能表现上,Gemma 在关键基准测试集上大大超过了更大的模型,同时还严格遵守了我们对安全和负责任输出的标准。

针对开发者,谷歌方面说明,开发者可以基于自己的数据微调 Gemma 模型以适应特定应用需求,例如摘要或检索增强生成 (RAG)。Gemma 可支持多种工具和系统:

1、多框架工具:Gemma 提供 Keras 3.0、原生 PyTorch、JAX 和 Hugging Face Transformers 多个框架的参考实现,您可以选择熟悉的框架进行推理和微调。

2、跨设备兼容:Gemma 模型可以在笔记本电脑、台式机、物联网、移动设备和云端等多个主流设备类型上运行,支持广泛的 AI 功能。

3、前沿的硬件平台: 我们与 NVIDIA 合作,使用 NVIDIA GPU 来优化 Gemma 模型,确保业界领先的性能与前沿技术的整合应用。

4、基于 Google Cloud 的优化:Vertex AI 提供广泛的 MLOps 工具集,其中包含一系列微调选项和内置推理优化的一键部署功能。您可以使用完全托管的 Vertex AI 工具或自行管理的 GKE 来进行高级定制,以经济高效的方式自行选择部署在 GPU、TPU 或 CPU 基础设施上。

在负责任方面,Gemma 在设计时将 AI 原则放在首位。为了使 Gemma 预训练模型安全可靠,谷歌使用自动技术,从训练集中过滤掉特定的个人信息及其他敏感数据。此外,我们进行了大量的微调和人类反馈强化学习(RLHF),使指令微调模型与负责任的行为保持一致。

谷歌方面表示,为了解并降低 Gemma 模型带来的风险,谷歌进行了强有力的评估,包括手工红队测试、自动对抗性测试,以及对危险活动的模型能力评估。