研究人员推出xLSTM神经网络AI架构 并行化处理Token

IT之家今日(5月13日)消息,研究人员Sepp Hochreiter和Jürgen Schmidhuber在1997年共同提出了长短期记忆(Long short-term memory,LSTM)神经网络结构,可用来解决循环神经网络(RNN)长期记忆能力不足的问题。 而最近Sepp Hochreiter在arXiv上发布论文,提出了一种名为 xLSTM(Extended LSTM)的新架构,号称可以解决LSTM长期以来“只能按照时序处理信息”的“最大痛点”,从而“迎战”目前广受欢迎的Transformer架构。 据悉,Sepp Hochreiter在新的xLSTM架构中采用了指数型门控循环网络,同时为神经网络结构引入了“sLSTM”和“mLSTM”两项记忆规则,从而允许相关神经网络结构能够有效地利用RAM,实现类Transformer“可同时对所有Token进行处理”的并行化操作。 团队使用了150亿个Token训练基于xLSTM及Transformer架构的两款模型进行测试,在评估后发现xLSTM表现最好,尤其在“语言能力”方面最为突出,据此研究人员认为xLSTM未来有望能够与Transformer进行“一战”。

IT之家今日(5月13日)消息,研究人员Sepp Hochreiter和Jürgen Schmidhuber在1997年共同提出了长短期记忆(Long short-term memory,LSTM)神经网络结构,可用来解决循环神经网络(RNN)长期记忆能力不足的问题。

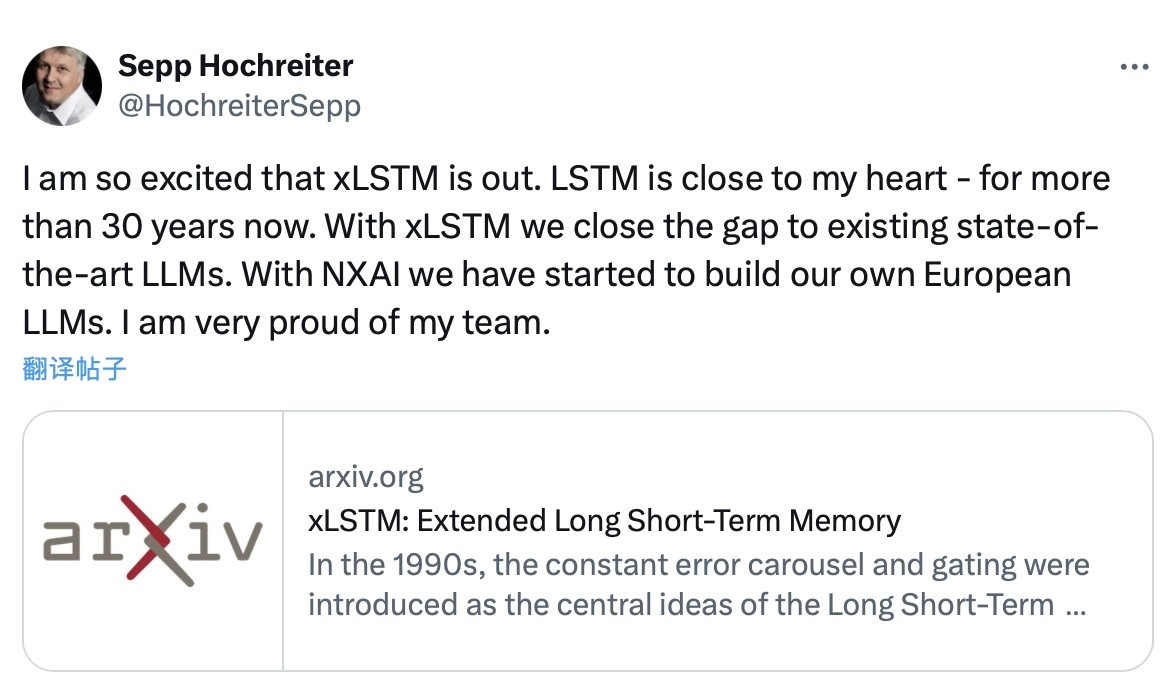

而最近Sepp Hochreiter在arXiv上发布论文,提出了一种名为 xLSTM(Extended LSTM)的新架构,号称可以解决LSTM长期以来“只能按照时序处理信息”的“最大痛点”,从而“迎战”目前广受欢迎的Transformer架构。

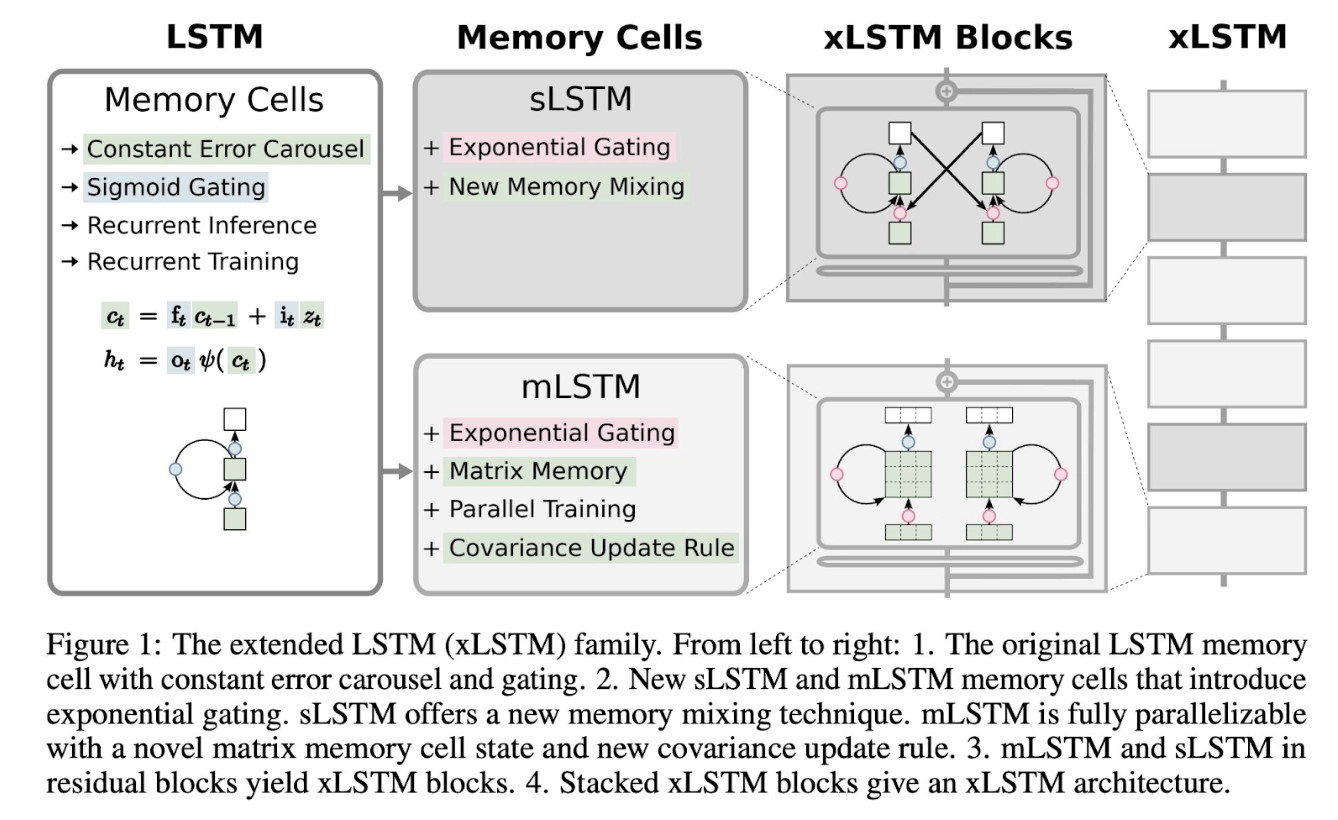

据悉,Sepp Hochreiter在新的xLSTM架构中采用了指数型门控循环网络,同时为神经网络结构引入了“sLSTM”和“mLSTM”两项记忆规则,从而允许相关神经网络结构能够有效地利用RAM,实现类Transformer“可同时对所有Token进行处理”的并行化操作。

团队使用了150亿个Token训练基于xLSTM及Transformer架构的两款模型进行测试,在评估后发现xLSTM表现最好,尤其在“语言能力”方面最为突出,据此研究人员认为xLSTM未来有望能够与Transformer进行“一战”。