员工称亚马逊AI聊天机器人Q“幻觉”严重 且泄露公司机密数据

IT之家今日(12月2日)消息,亚马逊于今年11月底推出名为Q的AI聊天机器人,不过根据国外科技媒体Platformer披露的一份内部文件,亚马逊员工称Q存在严重的“幻觉”问题,并泄露了包括AWS数据中心位置、内部折扣计划等诸多机密信息。 据悉,剑桥词典(Cambridge Dictionary)近日宣布2023年年度词汇为“hallucinate”(产生幻觉)。 hallucinate原意为似乎看到、听到、感觉到或闻到“一些不存在的东西”,通常是指用户在不良健康或者服用药物状态下产生的幻觉。 伴随着AI的崛起,hallucinate延伸为AI产生幻觉,生成错误的信息。 报告文件显示,亚马逊Q会产生幻觉,返回有害或不适当的聊天内容。例如,亚马逊Q会返回过时的安全信息,可能会让客户面临风险。 亚马逊淡化了员工讨论的重要性,并声称没有发现任何安全问题。然而,泄露的文件引发了人们对Q准确性和安全性的担忧,Q仍处于预览阶段,尚未正式发布。 一名员工将该事件标记为“sev2”,这意味着该事件非常严重,需要工程师加班第一时间修复。 Q被定位为ChatGPT的企业级版本,旨在比消费级工具更安全。然而,内部文件强调了Q提供不准确或有害信息的风险。 报道称Q除了存在严重的幻觉之外,还泄露了公司机密数据,包括AWS数据中心的位置、内部折扣计划和未发布的功能。 文章发表后,该发言人发布一份声明,反驳了员工的说法,称亚马逊Q没有泄露机密信息。

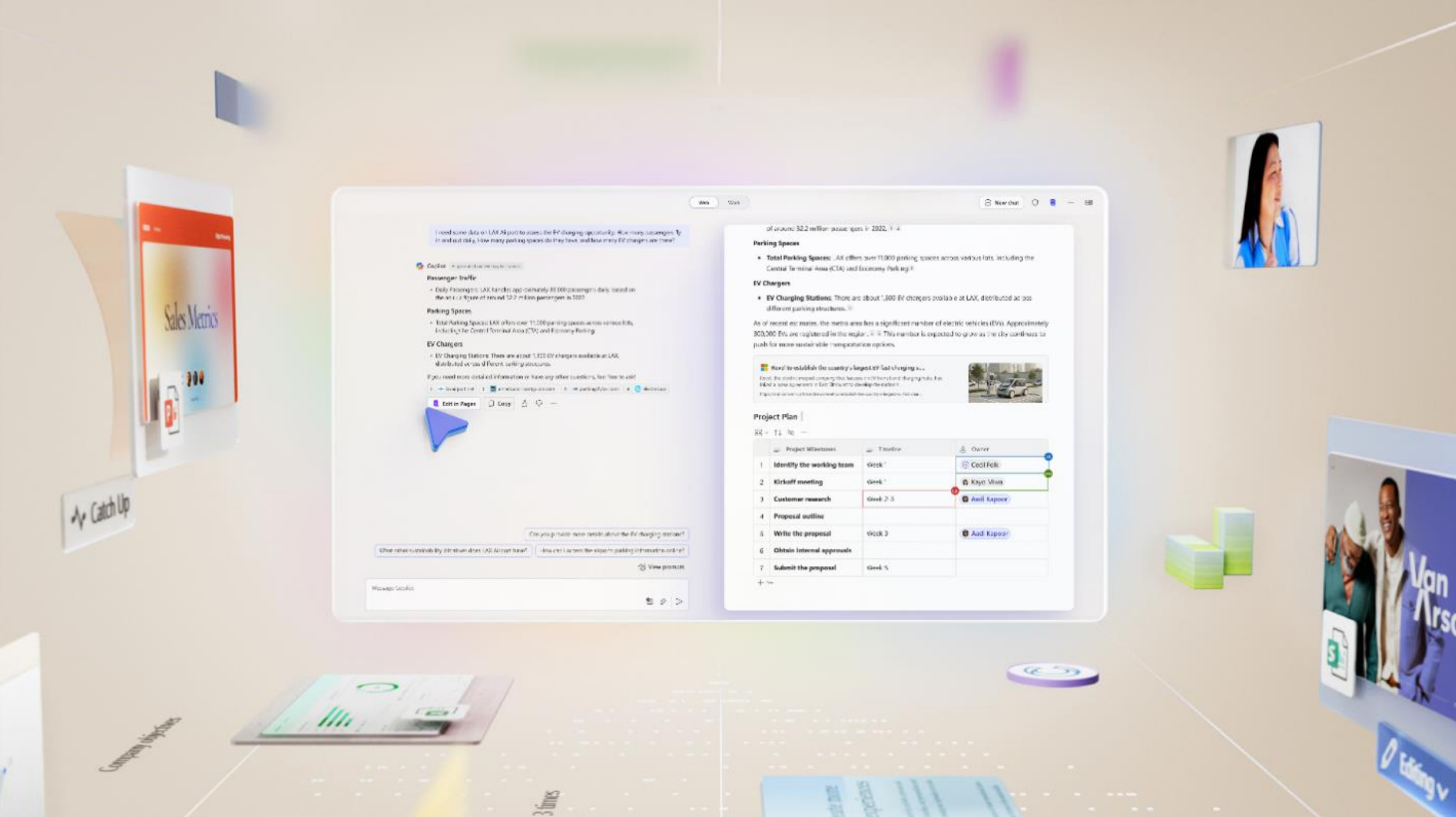

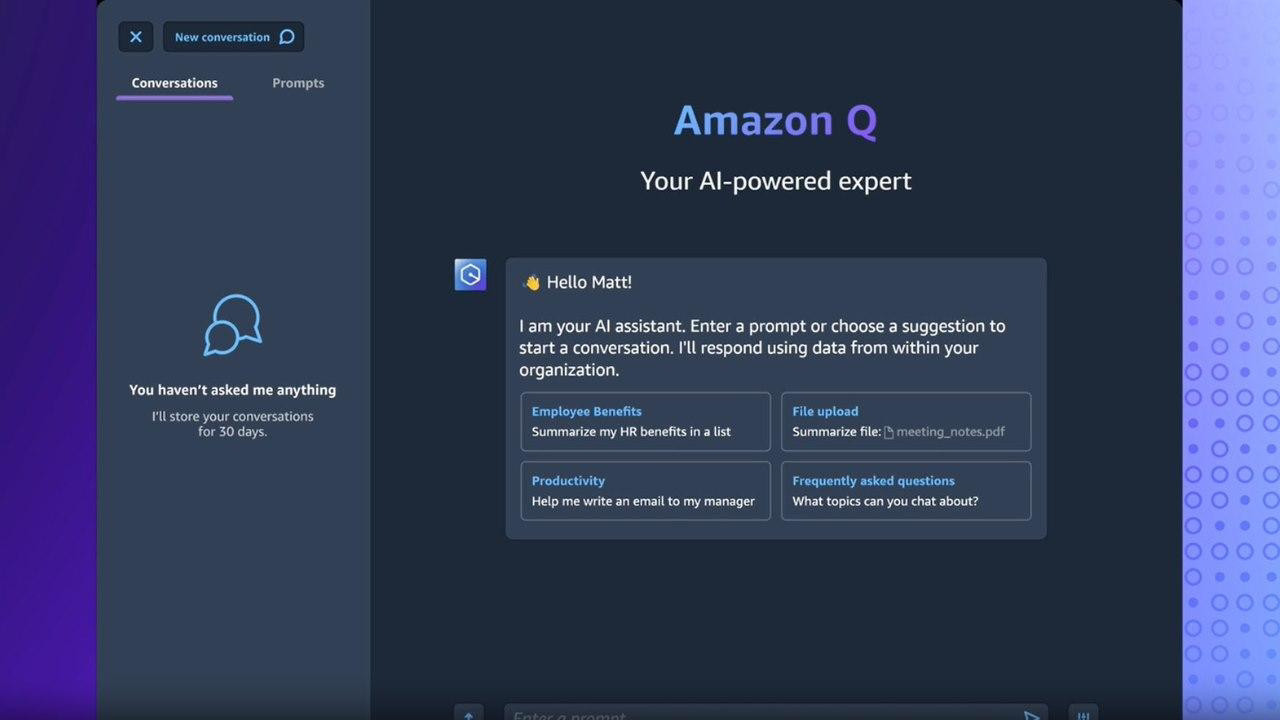

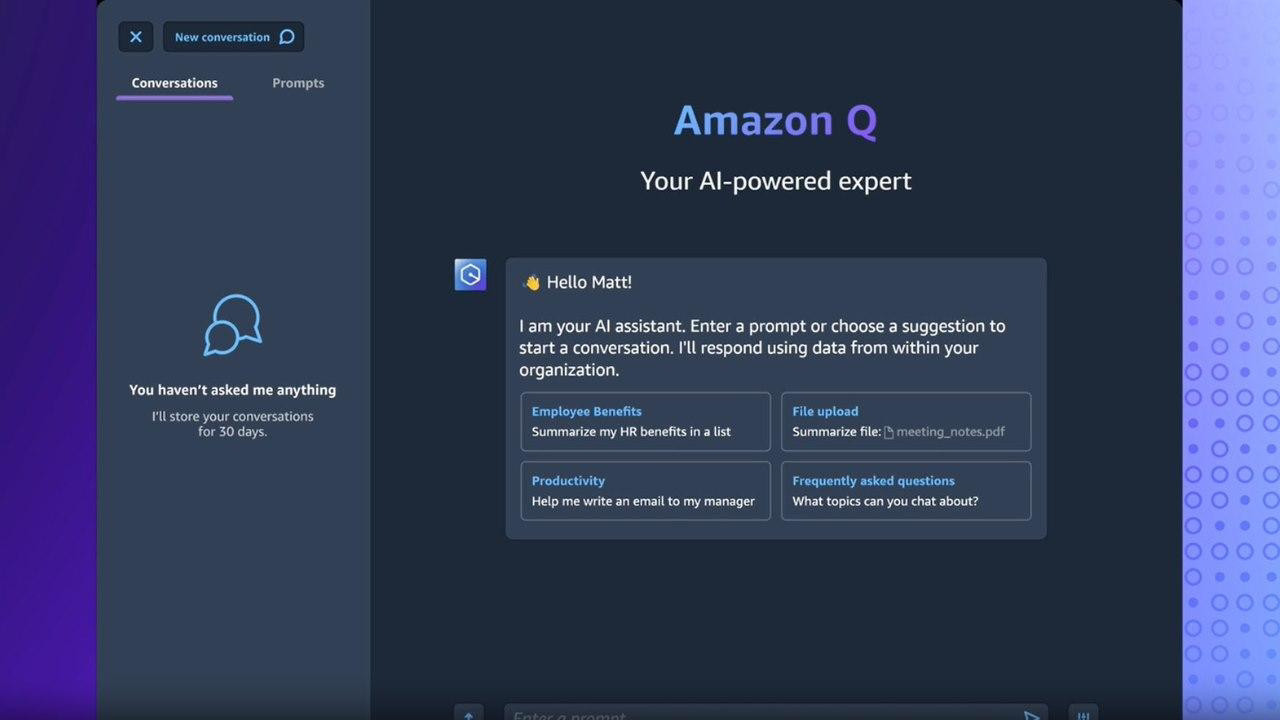

IT之家今日(12月2日)消息,亚马逊于今年11月底推出名为Q的AI聊天机器人,不过根据国外科技媒体Platformer披露的一份内部文件,亚马逊员工称Q存在严重的“幻觉”问题,并泄露了包括AWS数据中心位置、内部折扣计划等诸多机密信息。

据悉,剑桥词典(Cambridge Dictionary)近日宣布2023年年度词汇为“hallucinate”(产生幻觉)。

hallucinate原意为似乎看到、听到、感觉到或闻到“一些不存在的东西”,通常是指用户在不良健康或者服用药物状态下产生的幻觉。

伴随着AI的崛起,hallucinate延伸为AI产生幻觉,生成错误的信息。

报告文件显示,亚马逊Q会产生幻觉,返回有害或不适当的聊天内容。例如,亚马逊Q会返回过时的安全信息,可能会让客户面临风险。

亚马逊淡化了员工讨论的重要性,并声称没有发现任何安全问题。然而,泄露的文件引发了人们对Q准确性和安全性的担忧,Q仍处于预览阶段,尚未正式发布。

一名员工将该事件标记为“sev2”,这意味着该事件非常严重,需要工程师加班第一时间修复。

Q被定位为ChatGPT的企业级版本,旨在比消费级工具更安全。然而,内部文件强调了Q提供不准确或有害信息的风险。

报道称Q除了存在严重的幻觉之外,还泄露了公司机密数据,包括AWS数据中心的位置、内部折扣计划和未发布的功能。

文章发表后,该发言人发布一份声明,反驳了员工的说法,称亚马逊Q没有泄露机密信息。